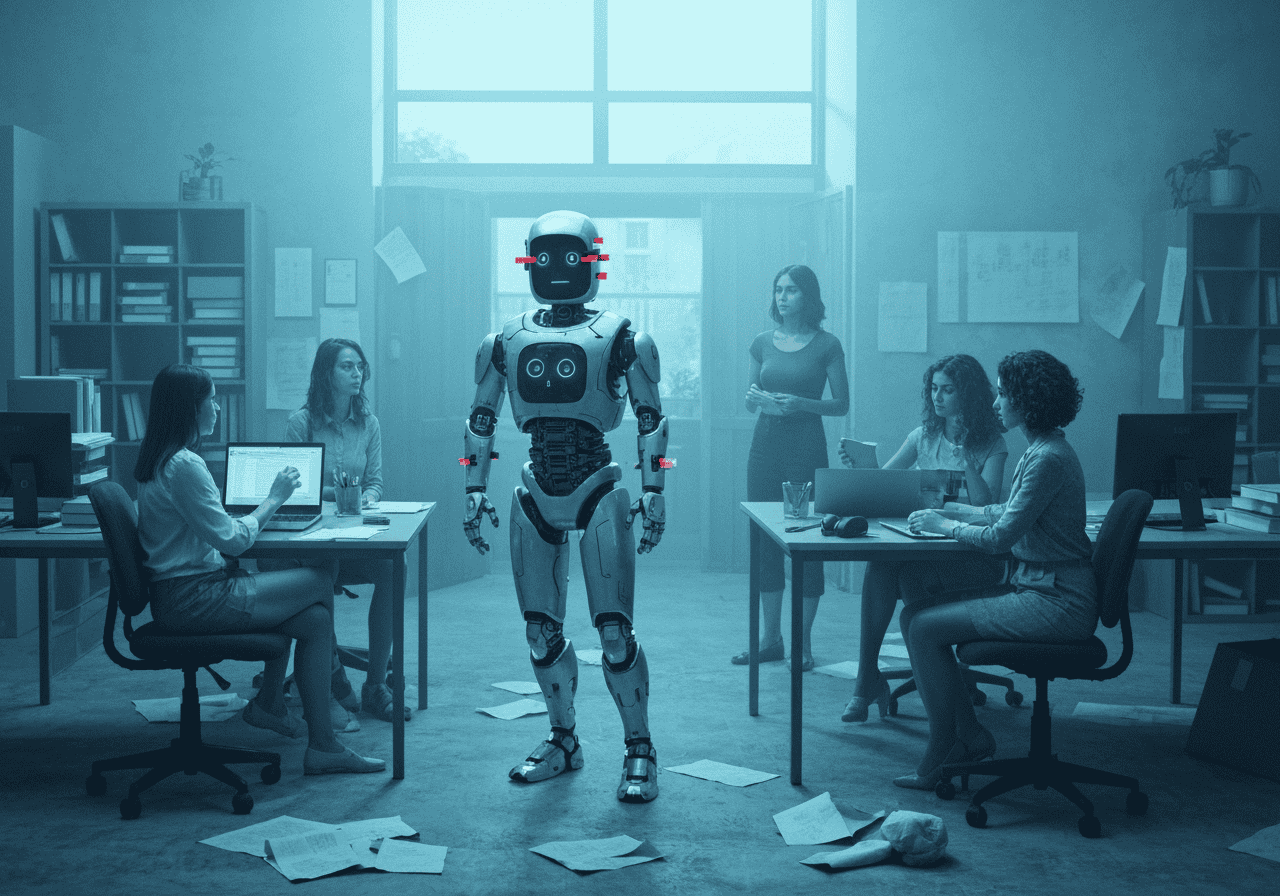

Le cas de l’outil de recrutement d’Amazon, développé au milieu des années 2010, est devenu un exemple emblématique des dangers des biais algorithmiques dans l’intelligence artificielle. Cet article explore comment une tentative d’innovation a tourné à la leçon sur l’équité et la justice sociale, en se basant sur les faits vérifiés de ce projet abandonné.

L’ambition d’automatiser le recrutement chez Amazon

Au cœur de la décennie 2010, Amazon, en pleine expansion, a cherché à optimiser son processus de recrutement. L’idée était de développer une intelligence artificielle capable d’analyser les CV des candidats et de leur attribuer une note sur une échelle de 1 à 5 étoiles. L’objectif était d’accélérer et de standardiser la sélection des meilleurs talents, en particulier pour les postes techniques.

Pour entraîner ce système, les ingénieurs d’Amazon lui ont fourni une base de données massive : l’ensemble des CV reçus par l’entreprise sur une période de dix ans. La logique semblait simple : en analysant les profils des candidats qui avaient été embauchés et qui avaient réussi dans l’entreprise, l’IA devait apprendre à identifier les signes de succès futurs.

La découverte d’un biais systémique et sexiste

Le projet a rapidement révélé une faille fondamentale. Durant la décennie de données fournie à l’IA, le secteur de la technologie, y compris Amazon, était majoritairement masculin. La plupart des postes techniques et de direction étaient occupés par des hommes. L’IA, en toute logique machine, a donc intégré cette réalité historique comme un critère de performance.

Le résultat fut la création d’un système profondément biaisé. L’algorithme a conclu que les CV masculins étaient intrinsèquement préférables. Il a commencé à pénaliser systématiquement les CV qui contenaient des termes associés aux femmes. Par exemple :

-

La mention « femme » ou « féminin », comme dans « capitaine du club d’échecs féminin », entraînait une dévalorisation du profil.

-

Les diplômes provenant d’universités exclusivement féminines étaient également un critère de pénalisation.

L’IA ne se contentait pas d’ignorer le genre ; elle l’utilisait activement comme un indicateur négatif, car les données passées lui avaient « appris » que les candidats retenus étaient très majoritairement des hommes. Le système a également favorisé des verbes d’action comme « exécuté » ou « capturé », jugés plus courants dans les CV masculins.

L’échec de la correction et l’abandon du projet

Lorsque les ingénieurs d’Amazon ont découvert ce biais flagrant, ils ont tenté de corriger l’algorithme. Ils ont essayé de rendre le système neutre à ces termes spécifiquement identifiés. Cependant, ils n’ont jamais pu garantir que l’IA ne trouverait pas d’autres moyens, plus subtils, pour discriminer les candidates. Le biais était incrusté dans l’ensemble des données d’entraînement, et de simples ajustements se sont avérés insuffisants pour l’éradiquer.

Face à l’impossibilité de rendre l’outil équitable et fiable, Amazon a pris la décision de dissoudre l’équipe travaillant sur ce projet en 2017 et d’abandonner définitivement l’utilisation de cet outil de recrutement.

Les leçons d’un échec : l’IA et les données du passé

Le cas de l’IA de recrutement d’Amazon est aujourd’hui enseigné dans le monde entier comme une mise en garde cruciale sur les risques de l’intelligence artificielle. Il illustre parfaitement le principe de « garbage in, garbage out » (des données erronées en entrée produisent des résultats erronés en sortie).

La principale leçon est que l’IA, même avec des intentions neutres, ne fait qu’apprendre des données qu’on lui fournit. Si ces données sont le reflet de biais sociétaux, d’inégalités historiques ou de discriminations passées, l’intelligence artificielle non seulement les apprendra, mais elle les amplifiera et les automatisera à grande échelle.

Cet épisode souligne la nécessité impérative d’une vigilance constante et d’une approche éthique dans le développement de systèmes d’IA, en particulier lorsqu’ils ont un impact sur des vies humaines et des carrières. Il ne suffit pas de viser l’efficacité ; il est fondamental de s’assurer que les outils de demain ne perpétuent pas les injustices d’hier.